최근 몇 년 동안 대규모 언어 모델(LLMs)은 GPT-3, Codex, PaLM, LLaMA, ChatGPT 및 최근의 GPT4와 같은 모델 덕분에 큰 발전을 이루었습니다. 이러한 모델들의 뛰어난 성능 덕분에 LLMs의 잠재력은 인-컨텍스트 학습, 코드 생성 및 다양한 다른 NLP 작업에서 인공 일반 지능으로 점점 더 가까워지고 있습니다. 이러한 뛰어난 성과에도 불구하고 현재의 LLMs에는 현재 정보를 인식하거나 반응하는 능력이 없는 것, 정확하고 이해하기 쉬운 수학적 해결책을 제공하는 데 실패하는 경우가 잦은 것, 긴 로직 체인에서의 추론 불안정성과 같은 단점이 있습니다. 이러한 문제를 해결하기 위해 LLMs의 기억 부담을 줄이고 이러한 문제 해결 능력을 향상시키기 위해 외부 도구를 제공하는 연구 방향이 동기 부여되었습니다. 예를 들어, 웹 검색 엔진이나 질문-답변(QA) 시스템과 같은 도구를 포함하면 LLMs는 문제 해결을 위해 외부 리소스를 언제, 어떻게 사용할지 학습할 수 있습니다. 최근 연구에서는 GitHub 리소스, 신경망 모델(예: Huggingface 모듈) 및 코드 인터프리터(예: Python 인터프리터)와 같은 추가적인 외부 LLM 도구도 사용됩니다. LLMs는 복잡한 문제를 해결하기 위해 이러한 기술을 사용하기 전에 광범위한 청사진을 제공해야 합니다.

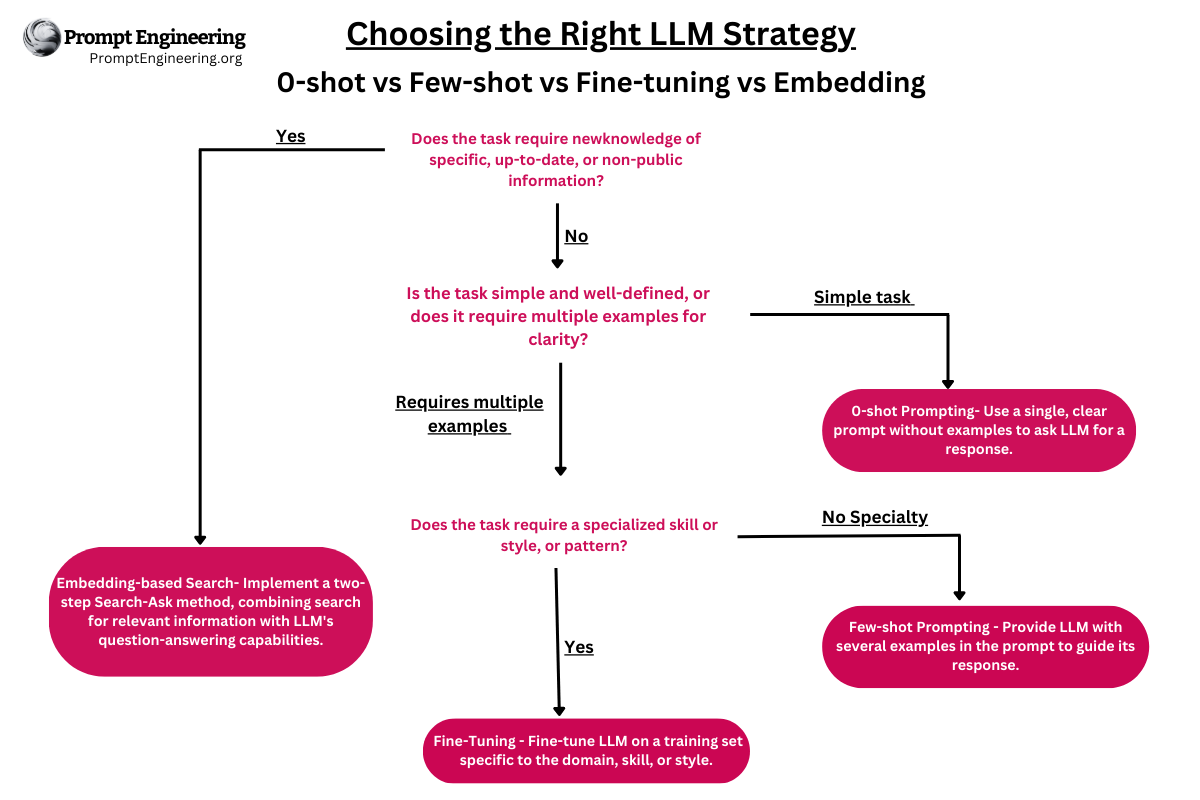

Figure 1 illustrates how CREATOR differs from a framework for general tool use.

도구를 갖춘 LLMs는 여전히 몇 가지 어려움을 겪고 있으며, 특히 다음과 같은 분야에 중점을 둡니다:

(1) 가능한 혁신적인 작업의 범위는 기본적으로 무한하지만, 현재의 연구는 몇몇 도구에만 집중되어 있습니다. 결과적으로 새로운 문제를 해결하기 위한 적절한 도구를 찾는 것이 어려울 수 있습니다.

(2) 언어 모델이 도구를 어떻게 효과적으로 사용할지 결정하는 현재의 방식은 본질적으로 복잡합니다. 전체 작업 처리 과정은 많은 계획을 필요로 하며, 이는 모델에 큰 인지적 부담을 주고 높은 학습 비용을 요구합니다.

(3) 실행 결과를 받은 후, 도구 사용 과정에는 명확하고 자동화된 오류 처리 메커니즘이 없습니다. 이 프레임워크의 정확성과 안정성은 아직 더 개선이 필요합니다.

이 연구에서, Tsinghua University와 University of Illinois (UC)의 연구자들은 이러한 문제점들을 새로운 시각에서 접근하려고 합니다. 그들은 LLMs를 도구의 개발자로서 강화하여 문제를 더 정확하고 유연하게 해결하려고 합니다, 도구의 단순한 사용자로서가 아니라.

결과적으로, 그들은 특정 문제를 해결하기 전에 기존 매개변수를 기반으로 도구를 개발하고 수정하는 LLMs의 능력을 활용하는 그들의 도구 개발 프레임워크인 CREATOR를 소개합니다. 그들은 그림 1에서 CREATOR와 전형적인 도구 사용 프레임워크 간의 파이프라인 변화를 보여줍니다. 도구 사용 프레임워크는 API의 사용을 더 효과적으로 선택하고 계획하기 위해 어떻게 추론을 사용하는지에 중점을 둡니다. 반면, 그들의 초점은 도구 세트의 다양화, 다양한 수준의 논리의 분리, 그리고 프레임워크의 회복력과 정확성 향상에 있습니다.

CREATOR는 네 단계로 나눌 수 있습니다:

- 창조(Creation): 문제를 기반으로 한 LLM의 추상적 추론 능력을 활용하여 문서화와 코드 구현을 통해 광범위하게 적용 가능한 도구를 만듭니다.

- 결정(Decision): 적절한 도구를 사용하여 도구를 언제, 어떻게 적용할지 결정합니다.

- 구현(Implementation): LLM이 문제를 해결하기 위해 도구를 사용하여 프로그램을 실행합니다.

- 수정(Rectification): 실행 결과를 기반으로 도구와 선택사항을 수정합니다.

그들은 처음에 MATH와 TabMWP라는 두 가지 기존 벤치마크를 사용하여 CREATOR에서 얼마나 효과적인지 테스트를 진행합니다. TabMWP는 문제 해결을 위한 다양한 표 형식의 설정을 제공하는 반면, MATH 데이터셋은 어려운 수학 경연 문제를 포함하고 있습니다. ‘특히, CREATOR 기반의 ChatGPT는 전통적인 사고의 연쇄(chain-of-thought, CoT), 사고의 프로그램(program-of-thought, PoT), 그리고 도구 사용 기준을 큰 차이로 능가하여 MATH와 TabMWP 데이터셋에서 각각 평균 정확도 59.7%와 94.7%를 달성했습니다.

또한, 그들은 기존 벤치마크가 도구 창조를 평가하기 위해 특별히 설계되지 않았기 때문에, 기존 도구나 코드 패키지를 사용하여 답변해야 하는 혁신적이고 어려운 도전을 포함하는 Creation Challenge 데이터셋을 제안합니다. 이 데이터셋을 사용하여 그들은 LLMs의 도구 제작 능력의 가치와 사용을 보여줍니다. 또한, 도구 개발이 지식 전송을 촉진하는 방법과 LLMs가 다양한 문제 맥락에 더 효과적으로 적응할 수 있게 해주는 도구 제작 능력의 다양한 정도를 보여주는 실험 결과와 사례 연구를 제공합니다.

CREATOR: Disentangling Abstract and Concrete Reasonings of Large Language Models through Tool Creation

Check Out The Paper.

요약

대규모 언어 모델(LLMs)은 다양한 작업을 위한 도구로 외부 API를 활용하는 데 있어 중요한 진전을 보여왔습니다. 그러나 그들의 도구 사용 능력은 적절한 API의 유용성과 암시적 추론의 불안정성, 특히 계획에 대한 추론과 실제 계산을 동시에 수행할 때에 제한됩니다. 이러한 제한 사항을 해결하기 위해, 우리는 LLMs가 문서화와 코드 구현을 통해 자신의 도구를 만들 수 있게 하는 새로운 프레임워크인 CREATOR를 제안합니다. CREATOR는 LLM의 능력을 추상적 도구 창조와 구체적 결정 실행의 두 가지 구별된 단계로 분리하여 LLM의 성능을 향상시킵니다. 우리는 어려운 수학 경연 문제로 구성된 MATH와 문제 해결을 위한 다양한 표 형식의 내용을 포함하는 TabMWP라는 두 가지 확립된 벤치마크에서 CREATOR를 평가합니다. 놀랍게도, CREATOR는 이 두 벤치마크에서 기존의 사고의 연쇄(chain-of-thought, CoT), 사고의 프로그램(program-of-thought, PoT), 그리고 도구 사용 기준을 크게 능가합니다. 또한, 우리는 2K의 다양한 질문으로 구성된 새로운 데이터셋인 Creation Challenge를 제시하여, 이러한 문제를 효과적으로 해결하는 데 있어 LLMs의 도구 창조 능력의 필요성과 이점을 강조합니다. 더욱이, 우리의 연구는 LLMs를 도구 창조자로 활용함으로써 지식 전송이 용이해지며, LLMs는 다양한 상황에 유연하게 대처할 수 있게 하는 도구 창조 능력의 다양한 수준을 보여줍니다. 우리의 연구는 LLMs의 잠재력을 극대화하고 진정으로 지능적이고 적응력 있는 AI 시스템을 향해 나아가는 유망한 방향을 제시합니다.