LLM 어플리케이션을 위한 Chunking Strategies

청킹은 텍스트를 작은 세그먼트로 나누는 과정으로, LLM 어플리케이션에서 중요한 최적화 기술입니다. 다양한 청킹 방법들이 있으며, 각 방법은 특정 상황에 적합할 수 있으며, 고정 크기 청킹, 재귀 청킹, 특수 청킹 등이 포함됩니다. 최적의 청킹 크기와 방법을 결정하려면 데이터 전처리, 청킹 크기 범위 선택, 그리고 각 청킹 크기의 성능 평가와 같은 여러 단계를 거쳐야 합니다.

청킹은 텍스트를 작은 세그먼트로 나누는 과정으로, LLM 어플리케이션에서 중요한 최적화 기술입니다. 다양한 청킹 방법들이 있으며, 각 방법은 특정 상황에 적합할 수 있으며, 고정 크기 청킹, 재귀 청킹, 특수 청킹 등이 포함됩니다. 최적의 청킹 크기와 방법을 결정하려면 데이터 전처리, 청킹 크기 범위 선택, 그리고 각 청킹 크기의 성능 평가와 같은 여러 단계를 거쳐야 합니다.

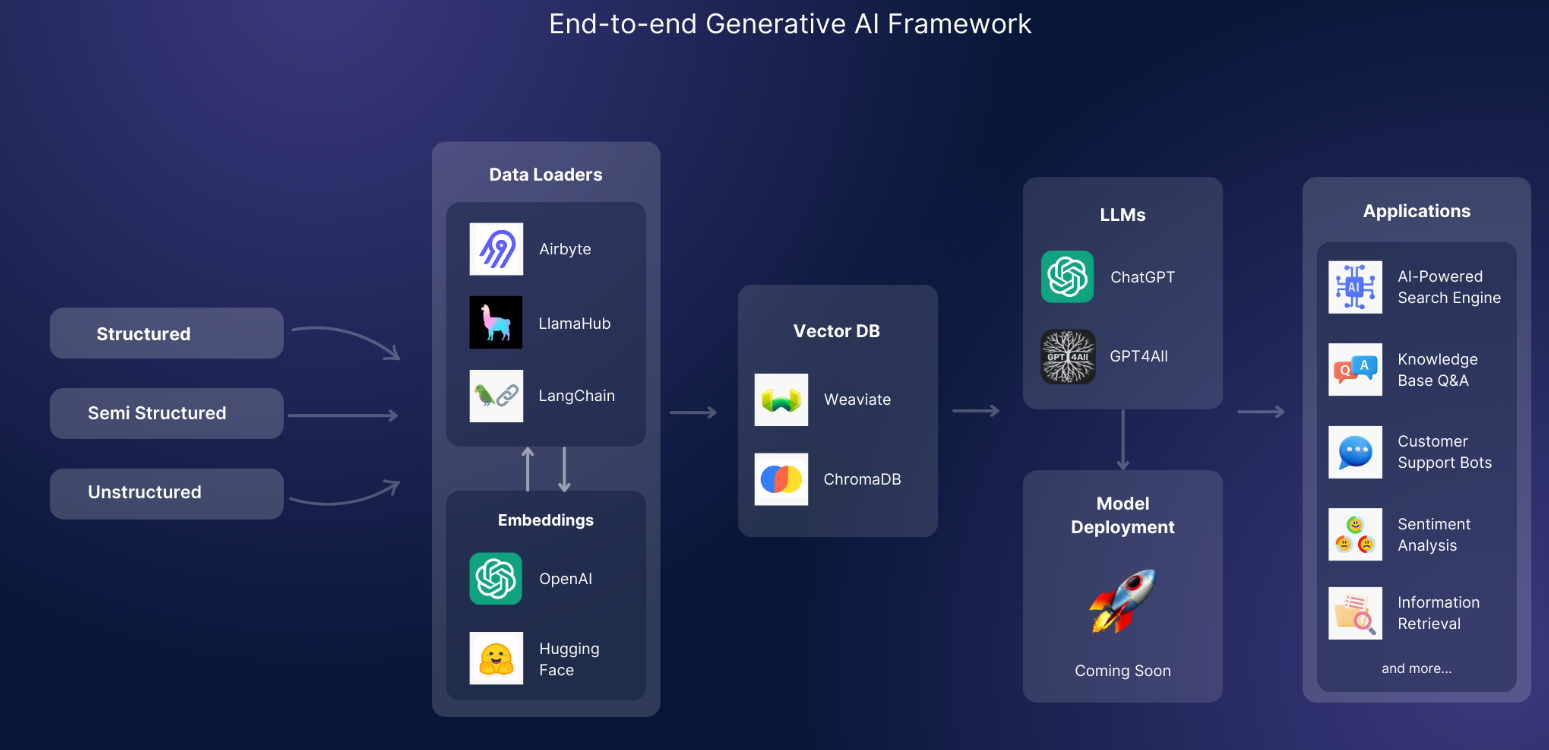

GenAI Stack은 대규모 언어 모델(Large Language Models, LLMs)을 애플리케이션에 통합하기 위한 엔드 투 엔드 프레임워크로, 데이터 처리의 복잡한 환경을 단순화하고, 환상 없는 AI 추론을 제공하여 실제 및 도메인 전문 지식에 기반한 출력을 보장합니다. 이 프레임워크는 AI 구동 검색 엔진, 지식 기반 Q&A, 감정 분석, 고객 지원 챗봇, 그리고 대량 문서의 정보 검색과 같은 다양한 사용 사례에서 활용할 수 있어, 개발자들이 AI의 잠재력을 효과적으로 활용하도록 돕습니다. GenAI Stack은 맞춤화와 제어를 제공하며, 기존 작업 흐름에 쉽게 통합하여 AI 개발 여정을 간소화하고 효율화합니다.