언어 모델

생성적 AI가 전통적인 데이터베이스를 뒤집는 10가지 방법

생성적 AI는 챗봇만을 위한 것이 아닙니다. 여기 AI와 기계 학습이 데이터 저장, 구조화, 쿼리 방식을 변화시키는 10가지 방법이 있습니다.

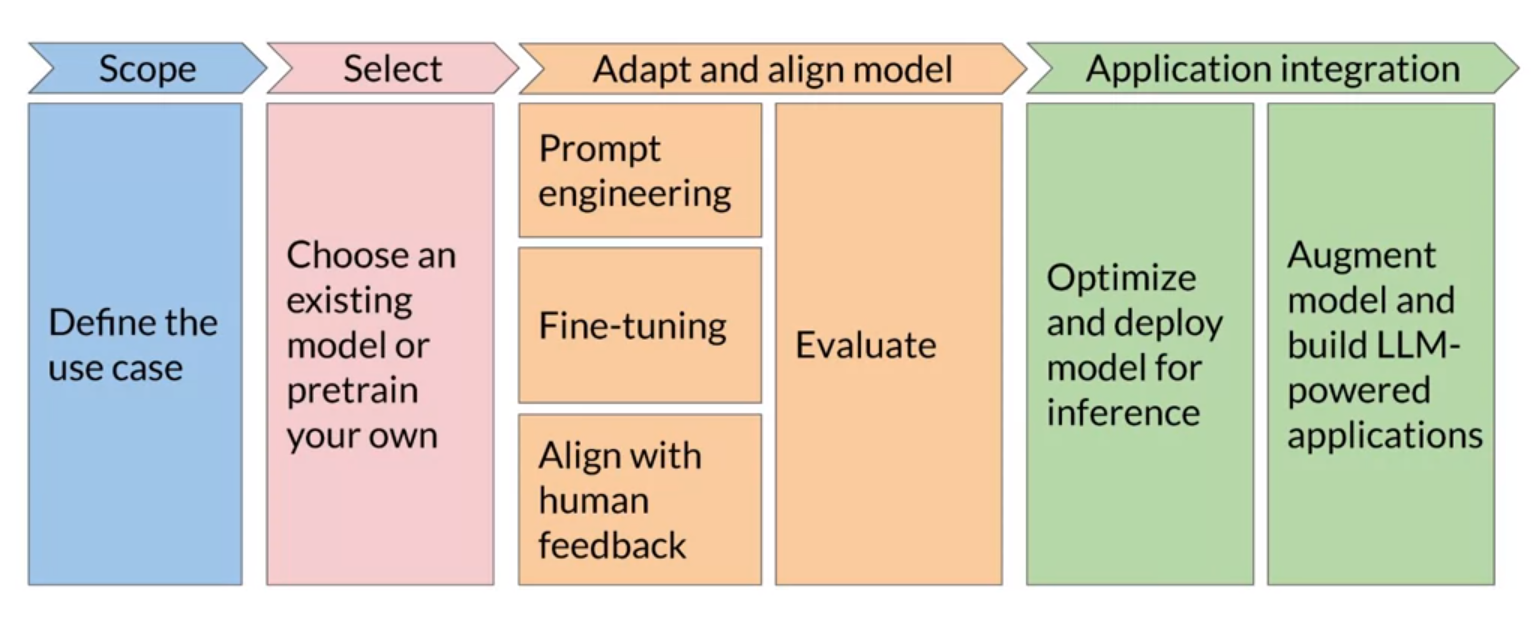

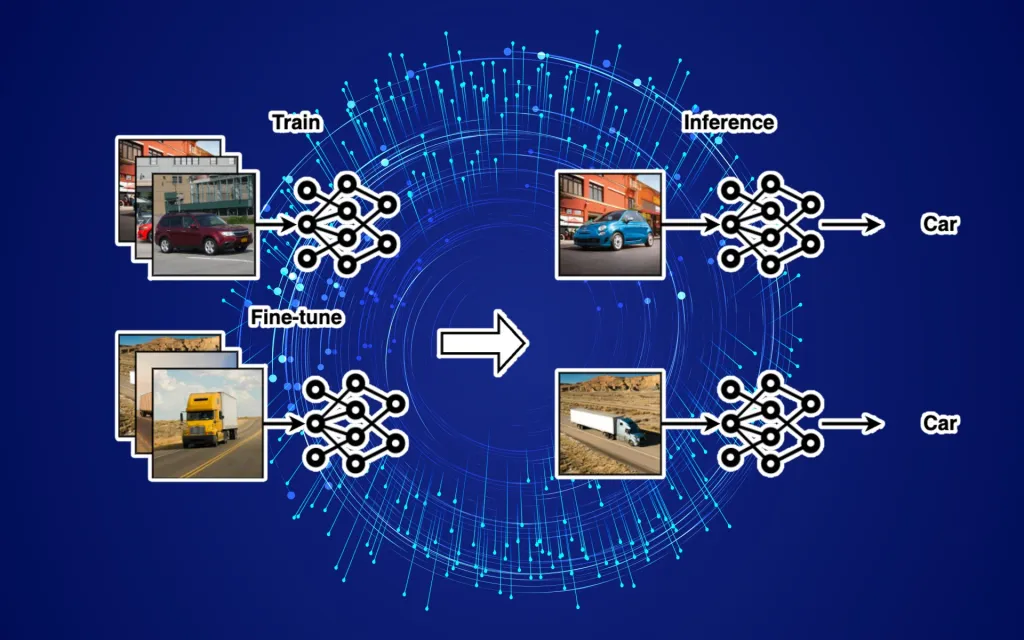

LLM fine-tuning에 대한 완전한 가이드

대규모 언어 모델 (LLM)의 미세 조정에 대한 글입니다. LLM은 기본적으로 광범위한 데이터셋으로 훈련되었지만 특정 애플리케이션에 적합하게 만들기 위해서는 종종 세밀 조정이 필요합니다. 세밀 조정은 모델을 새로운 데이터에 다시 훈련시키는 과정입니다. 이 글에서는 다양한 LLM 세밀 조정 기술과 그 사용 시점, 그리고 그것을 사용하지 않아야 할 시점에 대해 다루고 있습니다.

ChainForge 소개: 프롬프트 엔지니어링을 위한 시각적 프로그래밍 환경

ChainForge는 프롬프트 엔지니어링 전용입니다. 이것은 시각적 프로그래밍 환경을 제공하여 코드 작성 없이 작업을 용이하게 합니다. 사용자는 그래픽 인터페이스를 통해 프롬프트 최적화를 진행할 수 있습니다.

![[논문]Vicuna: GPT-4를 90%* ChatGPT 품질로 감동시키는 오픈소스 챗봇](https://www.jiniai.biz/wp-content/uploads/2023/08/OIG-1.jpeg)

[논문]Vicuna: GPT-4를 90%* ChatGPT 품질로 감동시키는 오픈소스 챗봇

Vicuna-13B는 사용자가 공유한 대화를 통해 LLaMA 모델을 미세조정하여 개발된 오픈 소스 챗봇입니다. 초기 평가에서는 GPT-4를 기준으로 Vicuna-13B가 OpenAI ChatGPT와 Google Bard의 품질의 90% 이상을 달성하며, 다른 모델들보다 90% 이상의 경우에서 더 나은 성능을 보였습니다. Vicuna의 훈련 비용은 대략 $300입니다.

LLMs의 기이한 세계에 대해 알아보기

Catching up on the weird world of LLMs 일요일에 North Bay Python에서 나는 ChatGPT, Google Bard, Llama 2와 같은 도구의 기반이 되는 기술인 거대 언어 모델(Large Language Models, LLMs)의 최근 몇 년 동안의 발전을 요약하려고 노력했습니다. 내 목표는 이 분야에 완전히 푹 빠져 있지 않은 사람들이 무슨 일이 일어나고 있는지 알 수 있도록 도와주는 것이었습니다….

![[논문]EmotionPrompt: LLM의 성능 향상을 위한 감정적 프롬프트의 연구](https://www.jiniai.biz/wp-content/uploads/2023/08/1600px_COLOURBOX.jpg)

[논문]EmotionPrompt: LLM의 성능 향상을 위한 감정적 프롬프트의 연구

연구자들은 대규모 언어 모델(LLM)의 성능 향상을 위해 감정적인 자극을 프롬프트에 포함시키는 EmotionPrompt 방식을 개발했습니다. 이 방식은 심리학에서 영감을 받아, 감정적 문장을 프롬프트에 추가하여 모델의 반응을 향상시켰습니다. 연구 결과, 네 가지 다른 LLM에서 여덟 가지 작업의 성능이 10% 이상 향상되었습니다. 이 연구는 인간-LLM 상호 작용을 향상시키기 위한 새로운 접근법을 제시하지만, 일반화와 효과성에 대한 추가 연구가 필요하다.

![[논문]LLMs의 도구 창조 능력 강화: CREATOR 프레임워크](https://www.jiniai.biz/wp-content/uploads/2023/08/unnamed1212.jpg)

[논문]LLMs의 도구 창조 능력 강화: CREATOR 프레임워크

대규모 언어 모델(LLMs)의 도구 사용 능력은 현재의 API와 암시적 추론의 제한에 의해 제한됩니다. 이를 해결하기 위해 CREATOR라는 새로운 프레임워크가 제안되었으며, 이는 LLMs가 자체 도구를 창조하게 함으로써 성능을 향상시킵니다. CREATOR는 기존 벤치마크에서 뛰어난 성능을 보여주며, 새로운 데이터셋인 Creation Challenge를 통해 LLMs의 도구 창조 능력의 중요성을 강조합니다. 이 연구는 LLMs의 잠재력을 극대화하고 AI 시스템을 발전시키는 방향으로 나아가는 것을 보여줍니다.

LLaMA 2 vs GPT-4: Which Large Language Model is Right for You?

가장 널리 사용되는 LLMs 중 두 가지, 즉 LLaMA 2와 GPT-4를 비교해보고자 합니다. 이들 모델이 어떤 것이며, 어떻게 작동하는지, 그리고 어떤 모델이 여러분에게 가장 적합한지 판단하는데 도움이 될 내용을 다루도록 하겠습니다.

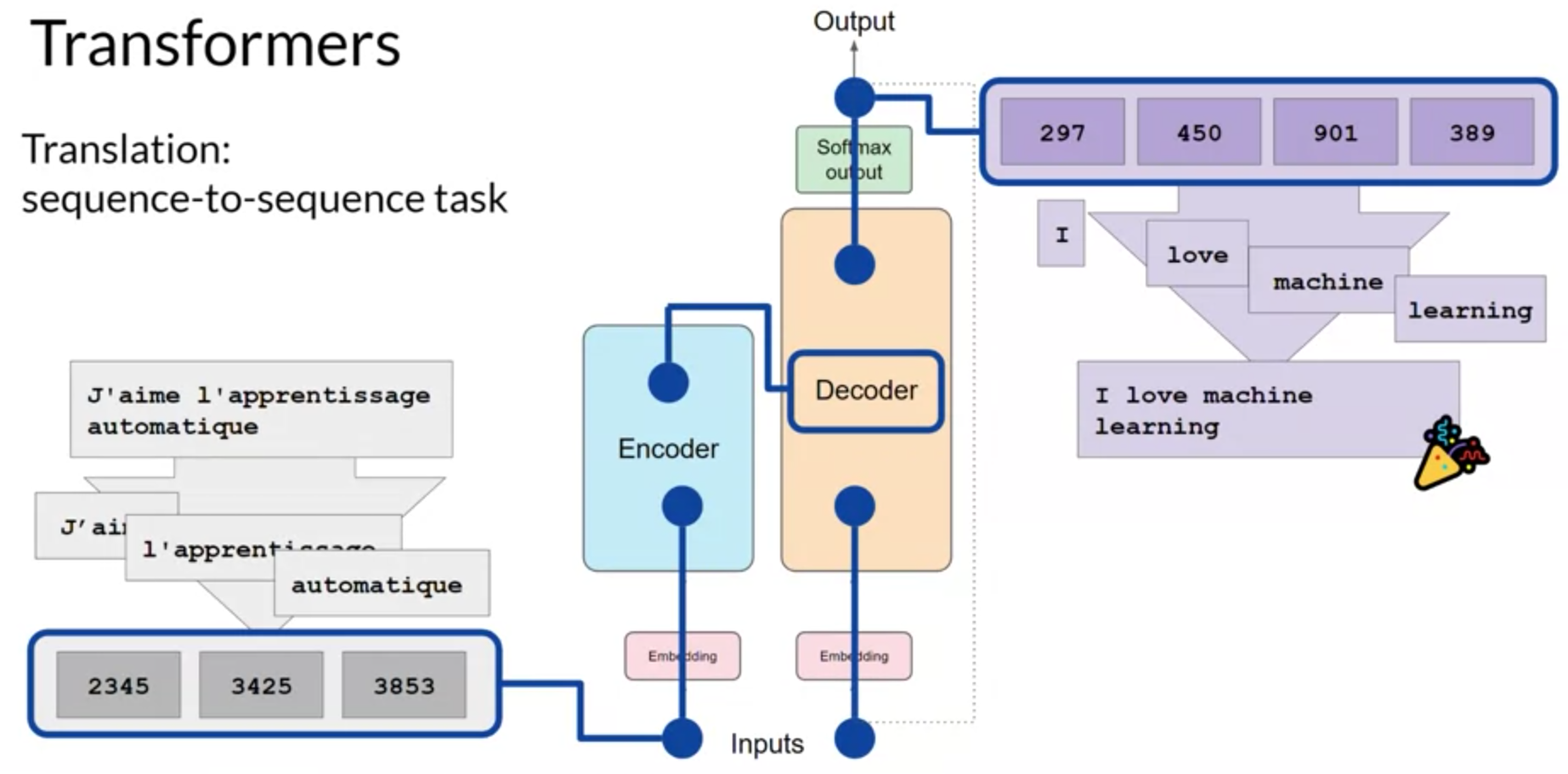

Transformer 아키텍처 및 Transformer 모델의 동작 원리

트랜스포머 아키텍처는 주로 어텐션 메커니즘을 활용하여 시퀀스 데이터를 처리합니다. 이 모델은 인코더와 디코더로 구성되어 있으며, 각각은 여러 개의 층으로 이루어져 있습니다. 어텐션 메커니즘을 통해 입력 시퀀스의 중요한 부분에 더 많은 집중을 하여, 문제에 따라 다양한 NLP 작업에 효과적으로 적용될 수 있습니다.