생성형 AI

생성형 AI는 데이터를 학습하여 새로운 정보나 콘텐츠를 생성하는 인공지능 기술입니다.

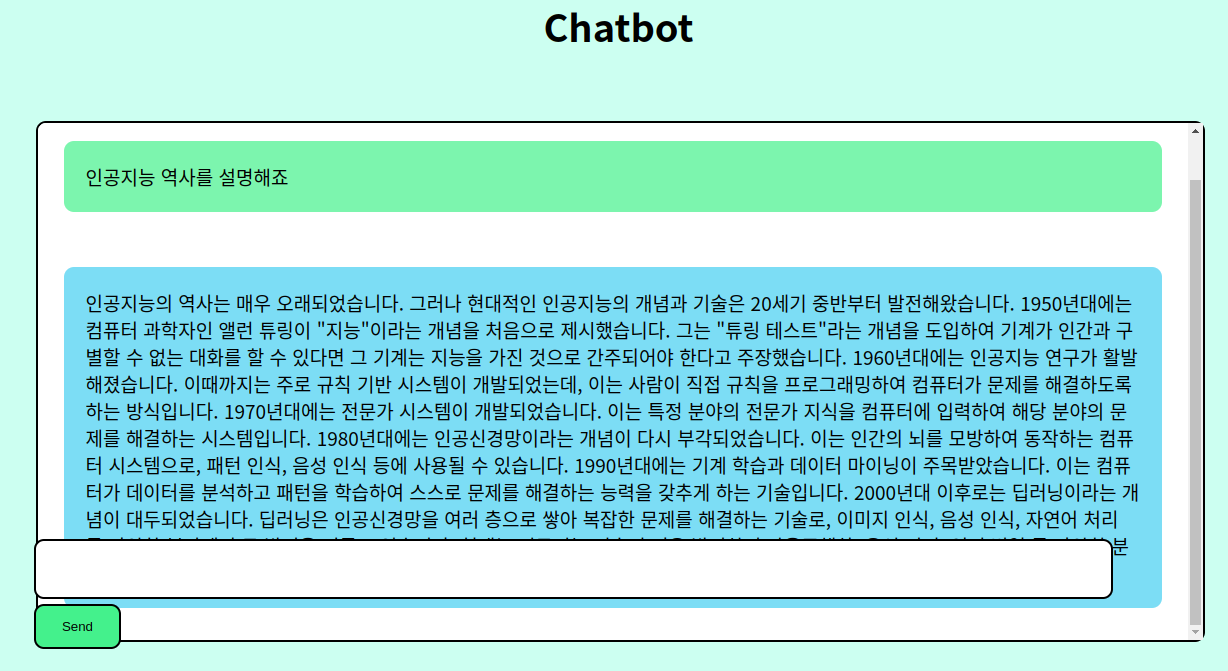

OpenAI API를 통해 자신의 데이터로 훈련된 챗봇 생성하기

이 글에서는 OpenAI API를 사용하여 자신만의 챗봇을 훈련시키고 테스트하는 방법과, 그것을 전 세계와 공유할 수 있는 웹 앱으로 만드는 방법에 대해 알아보겠습니다.

어떻게 GPT4 데이터 없이 코드 LLMs를 명령어 튜닝할까요?

How to Instruction Tune Code LLMs without GPT4 Data? Meet OctoPack: A Set of AI Models for Instruction Tuning Code Large Language Models [논문] OCTOPACK: INSTRUCTION TUNING CODE LARGE LANGUAGE MODELS 큰 언어 모델(LLM)의 사용성 및 전체 성능은 지시어를 통해 제공된 다양한 언어 작업을 미세 조정함으로써 향상될 수 있다는 것이 증명되었습니다 (instruction tuning). 시각, 청각,…

어떻게 LLM 또는 ChatGPT를 이용하여 데이터 기반의 지능형 QA 챗봇을 구축하는가?

How to Build an Intelligent QA Chatbot on your data with LLM or ChatGPT How to deploy a LLM chatbot LLM(대규모 언어 모델)에 의해 강화된 지능형 챗봇의 세계를 소개합니다. 이 글에서는 조직의 질문 응답 챗봇에 LLM을 원활하게 통합하는 방법에 대해 깊이 다루겠습니다. 고수준의 시스템 디자인 요소와 코드 구현의 세세한 부분까지 깊숙이 소개합니다. 여러분의 Postgres 데이터베이스를…

오픈소스 LLMs인 Llama 2와 Falcon을 사용하여 챗봇을 만드는 방법

이 블로그에서는 오픈소스 LLMs를 사용하여 챗봇을 만드는 방법을 배울 것입니다. 우리는 Lit-GPT와 LangChain을 사용할 것입니다. Lit-GPT는 튜닝과 추론을 위한 오픈소스 LLMs의 최적화된 모음입니다. 이는 Falcon, Llama 2, Vicuna, LongChat 및 기타 성능이 뛰어난 오픈소스 대형 언어 모델을 지원합니다.

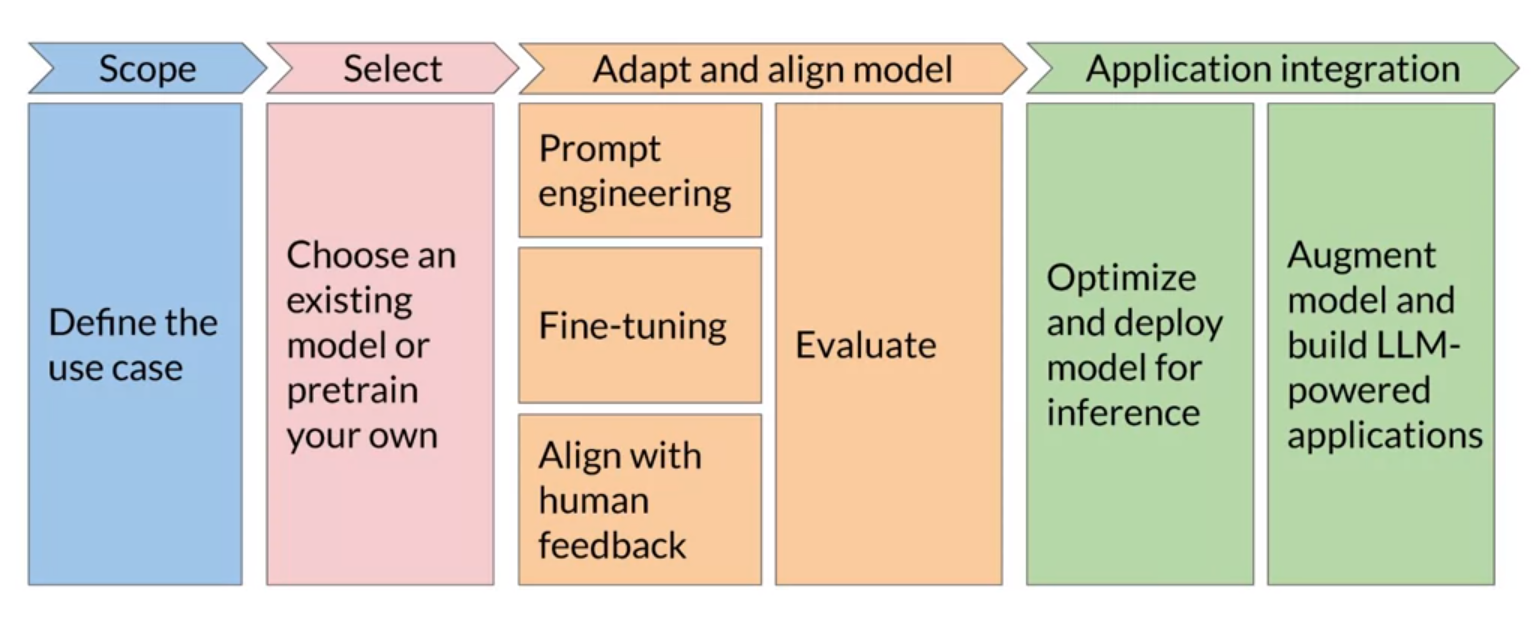

Generative AI project lifecycle

Generative AI 프로젝트의 수명 주기는 사용 사례를 정의하는 범위 설정, 기존 모델 선택 또는 자체 모델의 사전 훈련, 모델의 적응 및 조정, 그리고 응용 프로그램 통합으로 구성됩니다. 이 과정에서는 모델의 프롬프트 엔지니어링, 미세 조정, 인간의 피드백과 조정 및 성능 평가를 포함합니다. 마지막으로, 모델을 실제 환경에 배포하고, LLM 기술을 활용한 응용 프로그램을 개발합니다.

Generative AI의 새로운 패러다임

기술적 발전에 따라 인공 지능, 특히 대규모 언어 모델과 생성적 AI는 비즈니스 문제 해결에서 중요한 역할을 하고 있습니다. OpenAI와 같은 기업들은 AI의 상용화와 이용을 단순화하고 확장시켰습니다. 그러나 이러한 AI 기술은 도덕적, 법적 문제와 데이터 보안 문제를 일으킬 수 있습니다. 이러한 위험에도 불구하고, 기업들은 AI의 잠재력을 탐구하며, 적절한 관리와 실행을 통해 그 장점을 활용하고 있습니다.

생성적 AI가 전통적인 데이터베이스를 뒤집는 10가지 방법

생성적 AI는 챗봇만을 위한 것이 아닙니다. 여기 AI와 기계 학습이 데이터 저장, 구조화, 쿼리 방식을 변화시키는 10가지 방법이 있습니다.

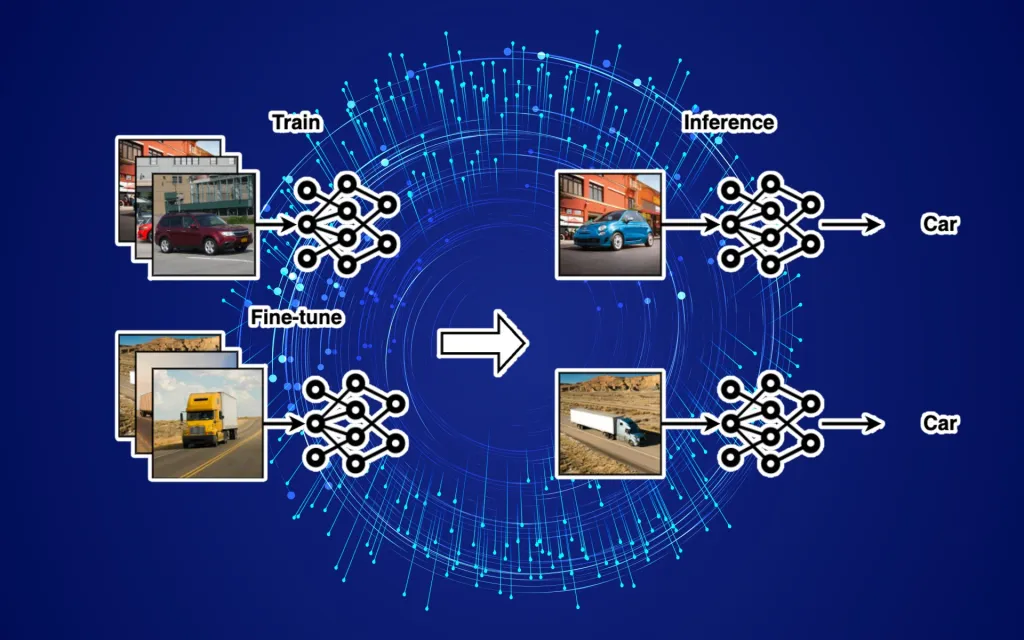

LLM fine-tuning에 대한 완전한 가이드

대규모 언어 모델 (LLM)의 미세 조정에 대한 글입니다. LLM은 기본적으로 광범위한 데이터셋으로 훈련되었지만 특정 애플리케이션에 적합하게 만들기 위해서는 종종 세밀 조정이 필요합니다. 세밀 조정은 모델을 새로운 데이터에 다시 훈련시키는 과정입니다. 이 글에서는 다양한 LLM 세밀 조정 기술과 그 사용 시점, 그리고 그것을 사용하지 않아야 할 시점에 대해 다루고 있습니다.

ChatGPT 프롬프트를 더 잘 작성하여 최상의 생성 AI 결과 얻는 방법

How to write better ChatGPT prompts for the best generative AI results 최상의 결과를 얻기 위해 효과적인 챗봇 프롬프트를 작성하는 것은 한 종류의 예술입니다. 여러분의 프롬프트 작성 능력을 향상시키는 방법은 다음과 같습니다. GIGO. 이는 1957년에 미국 육군의 윌리엄 멜린이 신문 기자에게 컴퓨터는 입력된 데이터에 따라 한계를 가진다고 설명했을 때부터 사용된 약어입니다. “Garbage In, Garbage Out”…

ChainForge 소개: 프롬프트 엔지니어링을 위한 시각적 프로그래밍 환경

ChainForge는 프롬프트 엔지니어링 전용입니다. 이것은 시각적 프로그래밍 환경을 제공하여 코드 작성 없이 작업을 용이하게 합니다. 사용자는 그래픽 인터페이스를 통해 프롬프트 최적화를 진행할 수 있습니다.