개발자를 위한 벡터 임베딩: 기초

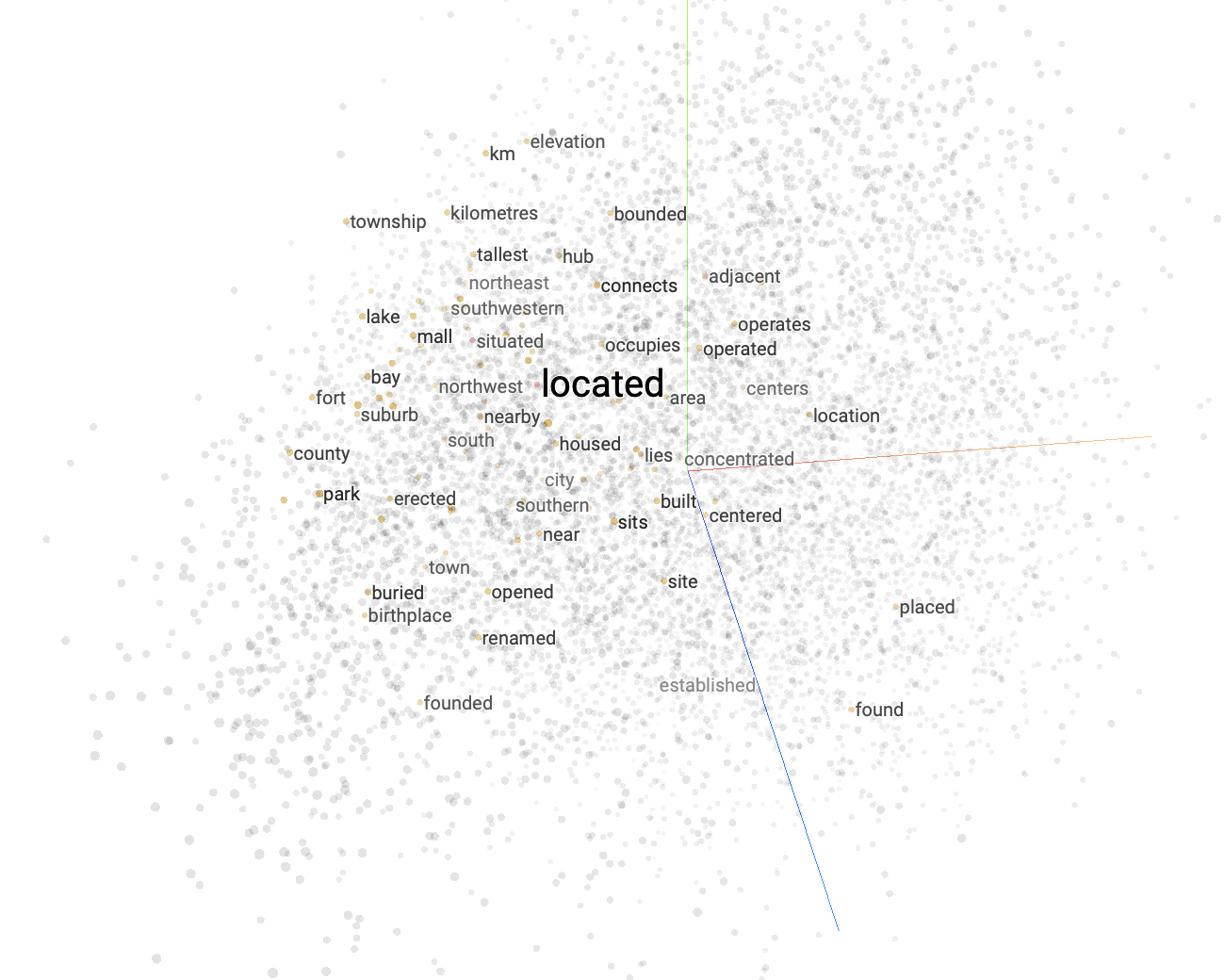

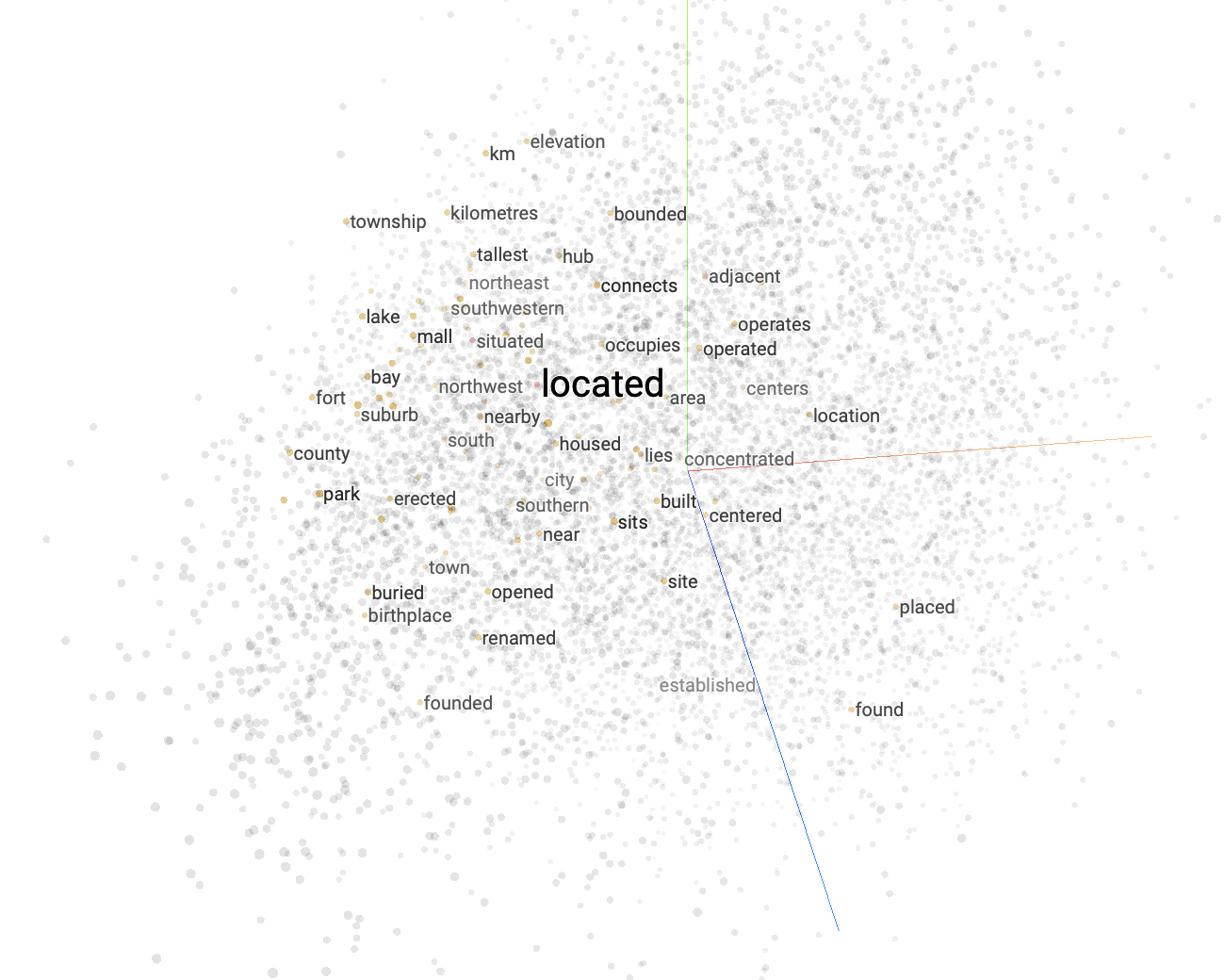

벡터 임베딩은 검색부터 AI 어시스턴트에 이르기까지 다양한 애플리케이션에서 사용되는 많은 머신 러닝 및 딥 러닝 알고리즘의 기본 구성 요소입니다. 이 분야에서 자신만의 애플리케이션을 구축하려고 한다면 어느 시점에는 벡터 임베딩에 부딪힐 것입니다.

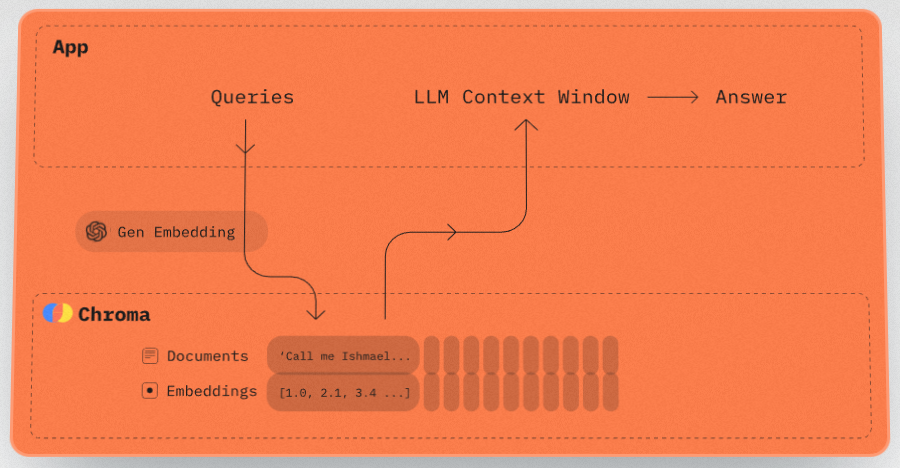

벡터 데이터베이스는 벡터 형식의 데이터(예: 임베딩)를 저장, 검색, 및 관리할 수 있게 해주는 데이터베이스 시스템입니다.

벡터 임베딩은 검색부터 AI 어시스턴트에 이르기까지 다양한 애플리케이션에서 사용되는 많은 머신 러닝 및 딥 러닝 알고리즘의 기본 구성 요소입니다. 이 분야에서 자신만의 애플리케이션을 구축하려고 한다면 어느 시점에는 벡터 임베딩에 부딪힐 것입니다.

크로마(Chroma)는 인기 있는 임베딩 제공자들에 대한 경량 래퍼를 제공하므로, 앱에서 이들을 쉽게 사용할 수 있게 해줍니다. 크로마 컬렉션을 생성할 때 임베딩 함수를 설정할 수 있으며, 이 함수는 자동으로 사용되거나, 직접 호출하여 사용할 수 있습니다.

Chroma DB는 벡터 데이터베이스로, 임베딩을 관리하고 검색할 수 있는 기능을 제공합니다. 이 데이터베이스는 컬렉션을 생성, 검색, 업데이트, 삭제하는 기능과 메타데이터 및 문서 내용에 대한 필터링, 기본 인증 및 정적 API 토큰 인증과 같은 인증 옵션을 포함하여 다양한 방법으로 데이터를 쿼리하고 관리할 수 있습니다. 클라이언트와 서버 설정을 통해 인증을 구성하고, 서버 실행 및 클라이언트 연결을 쉽게 설정하여 Chroma DB의 기능을 활용할 수 있습니다.

Chroma DB는 벡터 임베딩을 저장하고 검색하는 데 사용되는 오픈 소스 벡터 저장소입니다. 주요 용도는 대규모 언어 모델에 의해 나중에 사용될 메타데이터와 함께 임베딩을 저장하는 것입니다. 또한 텍스트 데이터에 대한 의미론적 검색 엔진으로도 사용할 수 있습니다.

Faiss는 고차원 벡터 공간에서의 유사성 검색을 위한 라이브러리로, 양자화, 인덱싱 구조, GPU 가속과 같은 기술을 활용하여 대규모 데이터셋을 효율적으로 처리합니다. 다양한 인덱싱 전략과 함께 실시간 검색에 적합할 수 있으며, C++로 구현되었으나 Python 래퍼를 통한 접근이 가능합니다.

청킹은 텍스트를 작은 세그먼트로 나누는 과정으로, LLM 어플리케이션에서 중요한 최적화 기술입니다. 다양한 청킹 방법들이 있으며, 각 방법은 특정 상황에 적합할 수 있으며, 고정 크기 청킹, 재귀 청킹, 특수 청킹 등이 포함됩니다. 최적의 청킹 크기와 방법을 결정하려면 데이터 전처리, 청킹 크기 범위 선택, 그리고 각 청킹 크기의 성능 평가와 같은 여러 단계를 거쳐야 합니다.

세맨틱 검색(Semantic search)과 검색 증강 생성(Retrieval-augmented generation, RAG)이 온라인 상호 작용을 재정의하는 시대에, 이런 발전의 기반이 되는 핵심 구성요소인 벡터 데이터베이스는 종종 간과됩니다. 대규모 언어 모델, RAG 또는 세맨틱 검색을 활용하는 어떤 플랫폼을 찾고 계신다면 이 글이 도움이 될 것입니다.